Mi az a Big Data? Mire használjuk? Mi az előnye?

A cégek már több mint 40%-a használ big data analitikát világszerte. A mindennapok során felhalmozódó információkat profin kiaknázó cégek 58%-kal nagyobb valószínűséggel érik el profitcéljaikat. Adatmogulok között ott van a Google, a Netflix, a Coca Cola.

Vegye fel velünk a kapcsolatot

A cikk tartalma

A Big Data története

A „Big Data” kifejezés valódi eredetével a kutatók nem tudnak egyetérteni. Egyesek a kifejezést a jelenleg 78 éves John R. Mashey Ph.D. amerikai informatikusnak (kockázati tőkebefektetők és technológiai társaságok tanácsadója, egy „ősi UNIX-személy”, aki 1973-ban kezdett el dolgozni a Bell Labs-nál és 1983-ban a Szilícium-völgybe költözött), akit a big data atyjának tartanak, nevéhez kötik és az 1990-es évekhez.

Míg mások úgy vélik, hogy ezt a kifejezést 2005-ben Roger Mougalas (csapata nyílt forráskódú elemzési infrastruktúrát épít, és elemzési szolgáltatásokat, technológiai trendelemzést nyújt) és cége az O'Reilly Media csoport találta ki. A Big Data nem teljesen új kifejezés, és nem csak az elmúlt két évtizedből származik. Vitathatatlan azonban, hogy az elmúlt évtizedben vált felkapott szóvá.

Az időszámításunk előtt 18 000-ből származnak a legkorábbi példáink az adatok tárolására és elemzésére, a számlálópálcák, amelyekbe bevéséseket végeztek a paleolit ősemberek, hogy nyomon követhessék mennyi ideig fog tartani az élelmiszerkészletük és ezzel előrejelzéseket készítsenek. Aztán i.e. 2400-ban eljött az abakusz (pálcákon csúsztatható golyókból álló tábla). Az első dedikált eszköz, amelyet kifejezetten számítások elvégzésére terveztek. Ekkortájt jelentek meg az első könyvtárak is, amelyek az első tömeges adattárolási kísérleteinket képviselik. Az ókori egyiptomiak i.e. 300 körül már megpróbálták rögzíteni az Alexandriai Könyvtárban a birodalmon belüli összes adatot. Becslések szerint a könyvtár 40 000 – 400 000 tekercset tartalmazott, ami manapság körülbelül 100 000 könyvnek felelne meg. Már az ókori világ vezetői is felismerték, hogy a különböző adatforrások kombinálása előnyt jelenthet más versengő birodalmakkal szemben.

A prediktív adatelemzés egyik legkorábbi formájának tekinthetjük az ókori római katonaság által használt részletes statisztikai elemzéseket. A Római Birodalomban gondosan elemezték a hadsereg statisztikáit, hogy meghatározhassák a seregek optimális elosztását a határok mentén. Ezen elemzések alapján a lehető leghatékonyabb módon tudták bevetni seregeiket az ellenséggel szemben. Ezek az elemzési technikák előnyhöz juttatták a római hadsereget a többi hadsereggel szemben.

1663-ban az angol John Graunt (demográfus, epidemiológus, rövidáru kereskedő) volt az első, aki statisztikai adatelemzést alkalmazott az Európát pusztító bubópestisről.

1886-ban az amerikai Herman Hollerith (eredetileg bányamérnök) feltalálta a lyukkártya-feldolgozó gépet, amelyet elektronikus számlálásra lehetett felhasználni. A lyukkártyák szendvicsként helyezkedtek el rézrudak között, ahol lyuk volt a kártyán, ott a rézrudak kontaktust létesítettek, és egy elektromos áramkör záródott. A készüléket arra tervezték, hogy fel lehessen dolgozni vele az 1880-as népszámlálás adatait, mert kézi feldolgozással ez több mint egy évtizedig tartott volna. 1896-ban Hollerith megalapította a New York-i Tabulating Machine Companyt a gép gyártására. Fúziók egész sora nyomán e vállalatból nőtt ki a hírneves IBM 1924-ben.

Az első nagyobb adatprojektet 1937-ben hozták létre az USA-ban, a Franklin D. Roosevelt adminisztráció rendelte el, miután a társadalombiztosítási törvény hatályba lépett. A kormánynak 26 millió amerikai és több mint 3 millió munkaadó befizetéseit kellett nyomon követnie.

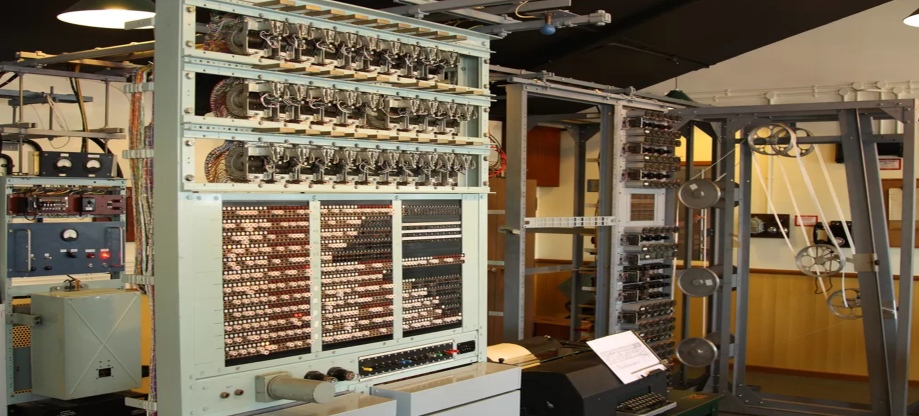

Az első adatfeldolgozó gép 1943-ban jelent meg, a britek fejlesztették ki a náci kódok megfejtésére a második világháború alatt. Ez a Colossus névre keresztelt eszköz 5000 karakter/másodperc sebességgel keresett mintákat az elfogott üzenetekben, tehát csupán néhány óra leforgása alatt fejtette meg a kódolt üzeneteket.

Az 1950-es évekig a legtöbb adatelemzés manuálisan és papíron történt. 1965-ben az USA kormánya megépítette az első adatközpontot, ahol több millió ujjlenyomat-készletet és adóbevallást tároltak. Később úgy döntöttek, hogy ezeket a rekordokat egy mágneses számítógépes szalagra helyezik át, amelyet egyetlen helyen kellett tárolni, ekkortól számítjuk az elektronikus adattárolás korszakának kezdetét.

A 21. század eleje óta az adatok előállításának mennyisége és sebessége az emberi megértés mértékét meghaladóan változott. 2003-ig az egész világon mindössze ötmilliárd gigabájtnyi adat volt. Ugyanennyi adat 2011-ben mindössze két nap alatt keletkezett. A világ teljes adatmennyisége már 4,4 zettabyte volt 2013-ban. 1 zettabyte egyenlő 1000 exabyte-tal, hozzávetőlegesen ennyi homokszem van a világon megtalálható összes strandon. Ez 2020-ra meredeken 44 zettabyte-ra növekedett, ami 300-szoros növekedést jelent 2005-höz képest. A 44 zettabyte 44 billió gigabyte-nak felel meg. Egyes becslések szerint naponta 2,5 kvintimillió bájt adat keletkezik. Eszelős mennyiségű adat!

A világ összes adatának 90%-a az elmúlt néhány évben keletkezett!

Robotizálás, PLC programozás szakértelemmel

Vegye fel velünk a kapcsolatot

A Big Data definíciója

A Gartner (egy amerikai technológiai kutató és tanácsadó cég) meghatározása szerint: A Big Data nagy volumenű, nagy sebességű, változatos információs eszközöket jelent, amelyek használata újabb feldolgozási formákat igényel, amikkel lehetővé válik a jobb döntéshozatal, a folyamatok optimalizálása, a folyamatokra való rálátás, a folyamatokba való betekintés.

A Big Data hatalmas adathalmazok gyűjteménye, amelyeket a normál számítási technikák nem tudnak feldolgozni. A Big Data különböző szervezetek által gyűjtött strukturált, félig strukturált és strukturálatlan adatok kombinációja, amelyekből információk bányászhatók elő, és ezek felhasználhatók a gépi tanulási projektekben, a prediktív modellezésben és más fejlett elemző alkalmazásokban.

A Big Data kifejezés nem csak az adatokra vonatkozik, hanem a különféle keretrendszerekre, eszközökre és technikákra is, amelyek biztosítják azokat a módokat, amik képesek kezelni ezt a mennyiségű adatot. A Big Data gyakran nem is egy fix adatbázis, hanem egy bizonyos forrásból folyamatosan termelődő adatsor, amiből ezért nem mintát veszünk, hanem folyamatos megfigyeléssel tudunk következtetéseket levonni belőle.

Tehát a Big Data nem egy konkrét eszköz vagy technológia, hanem egy fogalom, egy korszak jellemzése, amikor is a megszokotthoz képest nagyságrendileg nagyobb adatmennyiséget kell kezelni és feldolgozni, ami az addig megszokott eszközökkel már nem lehetséges. A weboldalak gyakori használata, a digitális szolgáltatások elterjedése, a közösségi média rendszeres használata rengeteg adatot biztosít, ami által alaposan meg lehet ismerni egy adott ipari folyamatot vagy akár emberi viselkedésmintákat, amik által már jó hatékonysággal lehet predikciókat megfogalmazni.

A Big Data-t három "V"-vel (volume, variety, velocity) szokták jellemezni:

- volume: nagy mennyiségű adat, ami segít a cég jövőjének formálásában és tevékenységeinek alakításában

- variety: a big data rendszerekben tárolt adattípusok sokfélesége

- velocity: a sebesség, amellyel az adatok nagy részét előállítják, összegyűjtik és feldolgozzák

Hogyan működik a Big Data

A Big Data számos különböző forrásból és alkalmazásból származó adatot egyesít. A Big Data elemzése magában foglalja a különböző trendek, minták és egyéb összefüggések felderítését hatalmas mennyiségű feldolgozatlan adaton belül annak érdekében, hogy adatvezérelt döntéseket tudjunk meghozni. A Big Data analitika olyan folyamatok és fejlett technológiák gyűjteménye, amelyeket a cégek, vállalatok használnak az adatvezérelt döntéshozatali modell elfogadásához. Ezek az eljárások jól ismert statisztikai elemzési módszereket, például klaszterezést (csoportosítást) és regresszióelemzést (egy vagy több független változó és egy függő változó közötti kapcsolat azonosítására és elemzésére szolgáló megközelítés, a közöttük lévő kapcsolat modellezése) alkalmaznak nagyobb adatkészletek elemzésére új eszközök segítségével, amelyek Big Data elemzési funkcióval és képességgel vannak felszerelve. Új stratégiákra és technológiákra van szükség a nagy adathalmazok tera- vagy akár petabájtos léptékű elemzéséhez. A mai világban a cégek mesterséges intelligencia eszközökre támaszkodnak nagy mennyiségű adat gyűjtésére, tárolására és elemzésére.

A nagy adatelemzés hatalmas mennyiségű adat összegyűjtésének, tisztításának (az ismétlődő vagy szükségtelen adatokat el kell távolítani), rendezésének és elemzésének folyamata. Bonyolult minták, trendek, rejtett összefüggések és egyéb felismerések kimutatására szolgál. A betekintések segítenek a cég vezetésének és az alkalmazottaknak gyorsabb, jobb és proaktívabb döntéseket hozni az üzlet fellendítése érdekében. Az adatvezérelt döntéshozatali modell hatékony módja az üzleti versenyképesség fenntartásának, a vevői elégedettség javításának és a bevétel növelésének.

Ahhoz, hogy érvényes és releváns eredményeket kapjunk nagy adatelemző alkalmazásokból, az adatelemzőknek részletesen ismerniük kell a rendelkezésre álló adatokat, és meg kell érteniük, hogy mit keresnek benne.

- Minden cégnek sajátos megközelítése van az adatgyűjtéshez. A modern technológiának köszönhetően a cégek ma már számos forrásból (belső és külső forrásokból) gyűjthetnek strukturálatlan, félig strukturált és strukturált adatokat, beleértve a felhőalapú platformokat, a mobilalkalmazásokat, az IoT-érzékelőket, a közösségi média felületeket, a webalkalmazásokat, a CRM- és az HRM-szoftvereket, stb. Az adattudósok idejük 50-80 százalékát az adatok összegyűjtésével töltik.

- A Big Data adatok tárolást igényelnek. Egyik tárolási megoldás lehet a felhőben, vagy a cég épületében szervereken, vagy akár mindkettő egyszerre. Az adatokat tetszőleges formában lehet tárolni, és kiválasztható az adatkészlethez igazodó feldolgozási mód és a szükséges feldolgozó motor igény szerint. A felhő alapú adattárolás egyre népszerűbb. Bármilyen fájl esetében, amit nem a saját gépünkön tárolunk, hanem valamilyen internetes szolgáltatás igénybevételével, akkor felhő alapú adattárolásról beszélünk. Előnyös, mert biztonságos, ha történne bármi a számítógéppel, mobiltelefonnal, a felhőben tárolt adatok nem vesznek el, mivel azok nem a készüléken találhatók. Az adatok bárhol, bármilyen készüléken hozzáférhetőek, helytől és időtől, valamint készüléktől függetlenül egy egyszerű bejelentkezéssel. Ezenkívül felhő alapon gyakorlatilag korlátlan mennyiségű adatot tárolhatunk. A különböző szervezetek továbbra is nehezen tudnak lépést tartani növekvő adataikkal, és megtalálni a módját azok hatékony tárolásának, mivel az adatmennyiség körülbelül kétévente megduplázódik.

- A hatalmas mennyiségű adatot használható formájúvá kell átalakítani. A fejlett elemzési technikák hatalmas adatokat tudnak átalakítani, hogy értelmezhetők legyenek. Miután fokozatosan nő az igény az adatok gyors elemzésére – jellemzően a döntéshozás és a folyamatok fejlesztéséhez, az összefüggések megkereséséhez és kiaknázásához - a cégek nyitnak az új technológiák és módszerek felé, hogy elérhetővé váljon számukra az, amit ma Big Data elemzésként ismerünk. A különböző vállalatok olyan fejlett elemzőplatformot keresnek és választanak, amely képes egyesíteni az analitikai feldolgozást a Big Data adattárolási igényeivel. Az adatok és az analitikai feldolgozás egyetlen platformba integrálása megszünteti az adatok adattárházból való kimozgatásával járó többletmunkát és átfutási időt. Ezen felül a célorientált analitikus feldolgozó motor megfelelő teljesítményt és rugalmasságot biztosít az új típusú elemzések elvégzéséhez. A masszív adatnövekedés és a mélyebb, gazdagabb tartalmú adatelemzés igénye már túlfeszítik egy hagyományos rendszer lehetőségeit. A teljesítmény, skálázhatóság és kezelhetőség mai elvárásai olyan új architektúrát követelnek, amely több terabájtnyi adaton történő ultragyors elemzésekhez nyújt megfelelő analitikai platformot.

A Big Data elemzési technikák közé tartozik:

- prediktív elemzés - a múltbeli adatok segítségével meghatározzák a lehetséges jövőbeni AI és ML trendeket és mintákat a piacon, feltérképezik azokat a lehetőségeket és kihívásokat, amikkel a cégnek várhatóan meg kell küzdenie.

- adatbányászat - ez egy olyan technika, amelyet az adatok rejtett mintáinak, trendjeinek és összefüggéseinek feltárására használnak, hogy a cégek ne ismételjék meg a korábbi hibákat.

- mély tanulás - ez a technika gépi tanulási algoritmusokat és eszközöket használ az adatok elemzésére, a legbonyolultabb absztrakt adatok mintáinak felkutatására használják, amelyek egyébként nem észlelhetők, emberi tanulási mintákat utánoz.

Robotizálás, PLC programozás szakértelemmel

Vegye fel velünk a kapcsolatot

A Big Data típusai

- Strukturált adatok

A szervezett adatok könnyen értékelhetők és rendezhetők, mivel előre meghatározott szervezeti jellemzőkkel rendelkeznek, és táblázatos sémában állnak rendelkezésre. A struktulált adat megfelelően szervezett, vagyis jól kereshető. A strukturált adatok olyan szabványosított formátum, amely releváns információkat szolgáltat egy weboldalról, és kategóriákba rendezi annak tartalmát. A strukturált adatok külön-külön mezőkben vannak, egymástól függetlenül, és a hozzáférés pontos módszerekkel történik. Emiatt a strukturált adatok igen jelentősek, mivel számos adatbázis helyről gyors adatgyűjtést tesznek lehetővé.

A strukturált adatokat gyakran táblázatokban tárolják, például Excel fájlok vagy SQL adatbázisok. A strukturált adatok könnyen beilleszthetők egy relációs adatbázisba. A strukturált adatkészlet különböző jellemzőire példák lehetnek például nevek, címek, dátumok nem önmagunkban, időjárási statisztikák, hitelkártyaszámok, stb. A strukturált adatok gyakori forrásai közé tartoznak például az érzékelőkből gyűjtött adatok, webnaplók, hálózati adatok, valamint kiskereskedelmi vagy e-kereskedelmi adatok. Strukturált adatok generálhatók úgy is, hogy az emberek táblázatokat vagy adatbázisokat töltenek ki számítógépekről.

- Strukturálatlan adatok

A strukturálatlan adatok olyan információkra utalnak, amelyek nem tartalmaznak előre meghatározott fogalmi jelentéseket, és amelyeket a hagyományos adatbázisok vagy adatmodellek nehezen érthetnek meg vagy elemezhetnek. A strukturálatlan adatokat gyakran kvalitatív adatoknak nevezik, mivel nem elemezhetők vagy dolgozhatók fel hagyományos módszerekkel a strukturált adatokhoz használt szokásos módszerekkel. Mivel a strukturálatlan adatoknak nincsenek meghatározott kapcsolatai az adatpontok között, ezért nem szervezhetők relációs adatbázisokba. A strukturálatlan adatok tárolásának módja jellemzően egy NoSQL adatbázis vagy egy adattó (képes nagy mennyiségű, különböző típusú adatok eredeti formában történő tárolására).

A strukturálatlan adatokat nehéz elemezni. A legtöbb Big Data strukturálatlan adatokból áll, a becslések szerint a strukturálatlan adatok az összes adat kb. 80%-át teszik ki. Adatbányászati technikák használhatók az adatok strukturálására. Strukturálatlan adat például dátumok önmagunkban, mérőszámok, videó- és hangfájlok, mobiltevékenységek, műholdfotók.

- Félig strukturált adatok

A strukturálatlan és strukturált adatok kombinációja a félig strukturált adatok. Ennek eredményeként magában foglalja a strukturált adatok bizonyos jellemzőit, de nem rendelkeznek egyértelműen meghatározott adatséma vagy adatmodell szerinti struktúrával. A félig-strukturált adatok olyan adatok, amelyek általában egy adatbázisból vagy fájlból származnak, és amelyek nem illeszkednek teljesen a hagyományos adatbázisok tábláinak és mezőinek modelljéhez. A félig-strukturált adatok lehetnek olyan adatok, amelyek XML-ben vagy JSON-ben tárolódnak.

A mesterséges intelligencia és a gépi tanulás területén a félig-strukturált adatok nagyon fontosak lehetnek az adatelemzési és előrejelzési feladatok elvégzéséhez. Az ilyen adatokból kinyert információk lehetnek fontosak az üzleti döntések meghozatalához, a fogyasztói szokások elemzéséhez, az ügyfél-elégedettség vizsgálatához, az ipari gyártás optimalizálásához, vagy akár a biológiai adatok elemzéséhez.

Robotizálás, PLC programozás szakértelemmel

Vegye fel velünk a kapcsolatot

A Big Data előnyei és kihívásai

Minden vállalkozás profitálhat a Big Data elemzéséből. A Big Data elemzése segít az innovációban és az üzleti átalakulásban. Bármilyen iparágban használható, és testreszabható a különböző cégek, vállalatok igényeihez mérten.

Előnyök:

- gyorsabb és hatékonyabb döntések - az adatok segítségével gyors döntések hozatala ebben a versengő világban versenyelőnyt biztosít

- költségek csökkentése és az erőforrások optimalizálása - az adatok segíthetnek a cégeknek csökkenteni a pazarlást és átfogóan felhasználni erőforrásaikat, növelhetik az üzleti bevételeket, a nyereséget

- kutatás-fejlesztés - a vevői igények és a piaci igények megértése segíti a cégeket a termékek és szolgáltatások fejlesztésében, az innováció a fejlődés hajtóereje

- nagyobb termelékenység - az automatizálás segíti elérni a termelékenység növelését, a Big Data segíti optimalizálni a munkafolyamatokat

- jobb kockázatkezelés - a kockázatok felderítése múltbeli és valós idejű adatok alapján történik, a cégek megtalálják a módját a veszteség nélküli megoldásokra

- jobb minőségű ügyfélélmény - a vásárlói élmény javítása az adatok alapján, növekvő ügyféllojalitás

A Big Data sok ígéretet rejt magában, de nem mentes a kihívásoktól.

Kihívások:

- adatok növekedése - a nyers adatok exponenciális növekedése, meg kell találni az adatok tárolásának és feldolgozásának módját

- Big Data eszköz kiválasztása - a rossz eszköz kiválasztása pénz elvesztését is eredményezheti, a Big Data technológiával való lépéstartás folyamatos kihívás

- biztonság biztosítása - a nem védett adatok a hackerek táptalajává válhatnak

Hol használják a Big Data-t

A New York-i tőzsde egy jó példa a Big Data-ra, amely naponta körülbelül egy terabájtnyi új kereskedelmi adatot generál.

- Vállalatok

A vállalatok Big Data adatokat használnak rendszereikben működésük javítására, a jobb ügyfélszolgálat biztosítására, személyre szabott marketing kampányok létrehozására és egyéb olyan intézkedések megtételére, amelyek növelhetik a bevételt és a nyereséget. Azok a vállalkozások, amelyek hatékonyan használják a Big Data adatokat, potenciális versenyelőnnyel rendelkeznek azokkal szemben, amelyek nem használják, mert gyorsabban és megalapozottabban tudnak üzleti döntéseket hozni. A Big Data értékes betekintést nyújt az ügyfelek viselkedési szokásaiba, amelyeket a cégek felhasználhatnak marketingjeik, promócióik finomítására az ügyfelek elkötelezettségének növelése érdekében. A Big Data adatok segítenek a konverziós arány növelésében is. Mind a múltbeli, mind a valós idejű adatok elemezhetők a fogyasztók, vásárlók változó preferenciáinak felmérésére, lehetővé téve a vállalkozások számára, hogy jobban reagáljanak az ügyfelek igényeire és szükségleteire.

- Szállítmányozás

Hatalmas mennyiségű közlekedési adatot használnak fel a GPS okostelefonos alkalmazások, amelyek segítségével a lehető legrövidebb idő alatt juthatunk el A pontból B-be. A kormányzati szervezetek és a műholdas fotók a GPS-adatok szállítói. A szállítmányozó cégek Big Data adatokra támaszkodnak ellátási láncaik kezelésében és a szállítási útvonalak optimalizálása során.

- Pénzügyi és banki szektor

A bankok nyomon követik a cégek működését a számlákon keresztül, és jelentést készíthetnek azokról a Big Data elemzésének köszönhetően, ami által a cégek csökkenthetik a kockázatpotenciált, elkerülhetik az esetlegesen várható negatív esemény bekövetkezési valószínűségét. De a bankok nyomon követik az ügyfelek költési szokásait és egyéb tevékenységeit is, hogy észrevegyék a szokatlan viselkedést és anomáliákat, amelyek csaló, megtévesztő tranzakciókra utalhatnak.

- Energiaipar

Az energiaiparban a Big Data segít az olaj- és gázipari vállalatoknak azonosítani a lehetséges fúrási helyeket és figyelemmel kísérni a csővezeték-kiépítési, -szerelési, -lerakási műveleteket; illetve hasonlóképpen a közművek az elektromos hálózatok nyomon követésére használják a Big Data adatait.

- Orvostudományi kutatások

A Big Data adatokat az orvoskutatók felhasználják a betegség jeleinek és kockázati tényezőinek azonosítására, az orvosok pedig a betegek betegségeinek és egészségügyi állapotainak diagnosztizálására. Ezen túlmenően, az elektronikus egészségügyi nyilvántartásokból, közösségi oldalakról, az internetről és más forrásokból származó adatok kombinációja naprakész információkat nyújt az egészségügyi szervezeteknek a fertőző betegségek fenyegetésével vagy kitörésével kapcsolatban.

- Kormányzatok

A kormányzati szervezetek hatalmas mennyiségű adatot gyűjtenek össze, de sokan közülük, különösen helyi szinten, nem használnak élvonalbeli adatbányászati és elemző eszközöket, hogy a legtöbbet hozhassák ki belőle. A társadalombiztosítási hivatal Big Data adatelemzést használ a csaló rokkantsági követelések és az adóelkerülés azonosítására. Egyéb kormányzati felhasználások közé tartozik a katasztrófaelhárítás, a bűnmegelőzés és az intelligens város kezdeményezések.

Gyakori kérdések

Milyen adattípusok számítanak Big Datanak?

Manapság már nemcsak a hagyományos adatbázistáblákban tárolt adatokról beszélünk, hanem már lehetőség van az alábbi helyekről is adatokat szerezni: weboldal elemzése, rendszernaplózási információk, internetes adatok webrobotokon keresztül, e-mail szerverek és hálózati használat, közösségi média adatok, blogok, messenger csevegések, streaming eszközökről származó adatok, robotika, orvosi feljegyzések, fotó és videó archívum, mobilalkalmazások követése, stb.

Hogyan járul hozzá a Big Data a személyre szabott marketinghez?

A Big Data személyre szabott marketinget tesz lehetővé az ügyfelek viselkedésének, preferenciáinak és demográfiai adatainak elemzésével. A marketingszakemberek ezeket az információkat arra használják, hogy célzott és személyre szabott tartalmat állítsanak elő egyes ügyfeleknek.

Mi az összefüggés az AI és a Big Data között?

A Big Data az AI éltető eleme. A Big Data az az alap, amelyre az AI algoritmusok épülnek és ami segítségével válnak egyre kifinomultabbá. A hatalmas és változatos adatkészletekhez való hozzáférés nélkül a mesterséges intelligencia (AI) nem rendelkezne az intelligens döntések és előrejelzések meghozatalához szükséges ismeretekkel és kontextussal. Minőségi adatok nélkül még a legkifinomultabb mesterséges intelligencia is használhatatlan.

Melyik iparág rendelkezik a legtöbb adattal?

Az egyik leginkább adatigényes iparág a pénzügyi ágazat. Az adatok jelentik az ágazat gerincét, mind a bankoknál, a tőzsdéknél vagy a fintech (digitális pénzügyi szolgáltató) cégeknél. A pénzügyi szektor hatalmas mennyiségű adatot termel. Gondoljunk itt a monetáris tranzakciókra vagy a valós idejű trendekre a tőzsdén.

Szüksége van a kis cégeknek a Big Data-ra?

Valójában szükségük van rá, hogy megismerjék a piaci trendeket, az ügyfelek preferenciáit. A Big Data segítségével a kisvállalkozások meghozhatják azokat az okos döntéseket, amelyeket ahhoz kellenek, hogy megelőzzék versenytársaikat és növeljék bevételeiket, versenyképességüket.

Kinek van több adata, mint a Google-nak?

Nincs ilyen. A következő legtöbb adattal a Twitter rendelkezik, utána az Amazon és a Facebook jön szinte fej-fej mellett és kissé marad le tőlük az Apple.

További blog cikkek

- Robotok az állattenyésztésben 3. rész

- Mi a hiperautomatizálás? Itt az 5. ipari forradalom?

- A hajózási ipar trendjei és csúcstechnológiája 2024-ben

- Mi a különbség a PLC és a PAC között

- IoT technológiák a mezőgazdaságban

- Robotikai trendek és előrejelzések 2023-ra, 1. rész

- Mit kell tudni a PLC- programozásról?

- Hogyan használhatjuk a PLC-t a mezőgazdaságban?

PLC programozás szakértelemmel

Több, mint 20 év tapasztalat PLC programozásban, ipari automatizálásban, robotikában, HMI programozásban, okosotthon automatizálásban, mezőgazdaság automatizálásban, járműipari programozásban.

Vegye fel velünk a kapcsolatot